Новые правила обработки директивы Allow текстового файла robots.txt

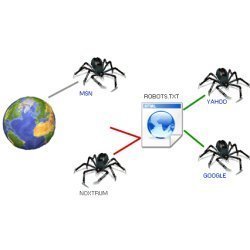

Команда Яндекс.Поиска сообщает о том, что начинают действовать новые стандарты обработки директивы Allow текстового файла robots.txt, которая разрешает доступ робота к частям сайта или к сайту целиком.

Отныне для правильной обработки директивы ее необходимо использовать, ориентируясь на порядковое следование: если для страницы сайта подходит несколько директив, то выбирается первая в порядке появления в User-agent блоке.

По заверениям Яндекса, через несколько недель будет внедрено изменение в обработке поисковым роботом директивы allow и отказ от учета порядка. Директивы будут сортироваться по длине префикса URL’а и применяться последовательно. Подобное нововведение позволит соответствовать международным стандартам применения директивы и упростит работу российских и зарубежных вебмастеров, у которых нередко возникали трудности при составлении файла robots.txt.

Также Яндекс настоятельно советует проверить соответствие новым стандартам всем тем, кто в файлах robots.txt использует директивы allow и disallow.

Новости по теме:

Яндекс на "Неделе Байнета" отключил ссылки

Яндекс рассказал, как изменился Рунет за последние 10 лет

Яндекс.Метрика приглашает всех желающих протестировать новый код счетчика